Technologie Przyszłości: Rozwój i Aplikacyjne Zastosowania Sztucznej Inteligencji

Data i miejsce: 25 kwietnia 2025, Akademia WSEI, Lublin, Polska

🌐 Strona konferencji: https://nx365.ai/warsztaty/

🎥 Nagrania z konferencji dostępne są na YouTube:

W dniu 25 kwietnia 2025 roku w murach Akademii WSEI w Lublinie odbyła się druga edycja warsztatów naukowych pod hasłem „Technologie przyszłości: Rozwój i aplikacyjne zastosowania sztucznej inteligencji”. Wydarzenie zgromadziło liczne grono ekspertów, naukowców oraz przedstawicieli przemysłu, stając się platformą do wymiany wiedzy na temat najnowszych trendów badawczych, studiów przypadków oraz praktycznych wdrożeń rozwiązań opartych na sztucznej inteligencji.

Konferencja skupiła się na prezentacji innowacyjnych technologii AI oraz ich wszechstronnych zastosowań w różnych dziedzinach życia i gospodarki.

Pierwszy wykład wprowadzający, zatytułowany „Technologie przyszłości – rozwój i aplikacyjne zastosowania sztucznej inteligencji”, wygłosił prof. Tomasz Rymarczyk.

Prelegent przedstawił szeroką wizję ewolucji technologii przyszłości, ze szczególnym uwzględnieniem roli sztucznej inteligencji i jej fundamentalnego wpływu na przemysł oraz gospodarkę. Omówił historię rozwoju AI, począwszy od jej teoretycznych podstaw, przez kluczowe osiągnięcia takie jak AlphaGo, Watson czy AlphaFold, aż po dynamiczny rozwój zaawansowanych modeli generatywnych i wielkoskalowych systemów językowych (np. GPT, BERT, LaMDA, Gemini, Llama).

Autor przedstawił potencjalne kierunki dalszego rozwoju AI, w tym koncepcję osobistych asystentów AI, postępującą automatyzację w różnych sektorach zawodowych oraz głębokie transformacje społeczne wynikające z integracji AI w codziennym życiu. Zwrócił również uwagę na ogromne możliwości oferowane przez technologie sztucznej inteligencji, jednocześnie podkreślając istotne wyzwania etyczne, społeczne i związane z bezpieczeństwem, które wymagają odpowiedzialnego podejścia i dalszych interdyscyplinarnych badań.

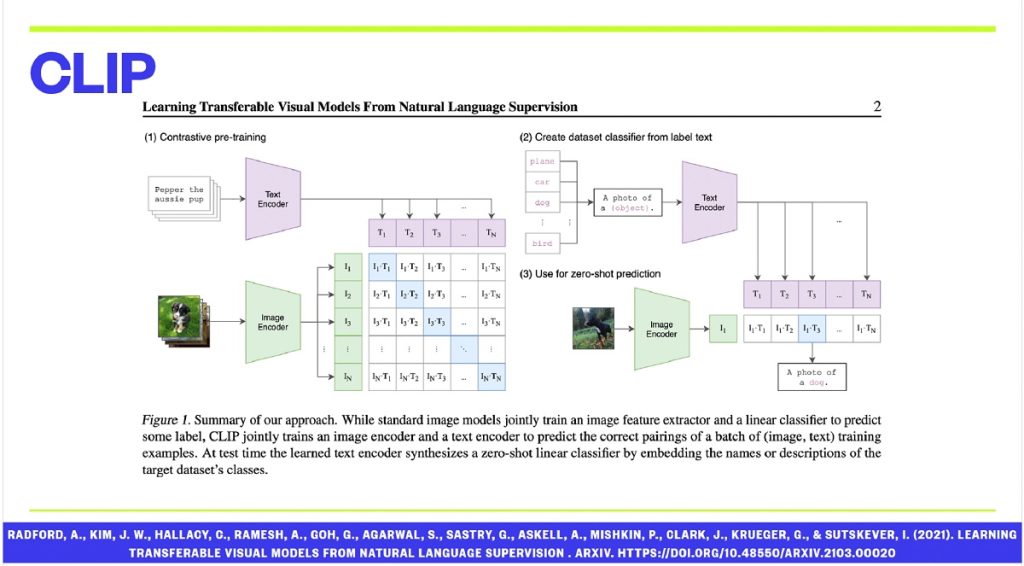

Następnie, dr Dariusz Wójcik w wykładzie technologicznym „Generatywna sztuczna inteligencja: od autoenkoderów wariacyjnych do latentnych modeli dyfuzyjnych” przybliżył słuchaczom ewolucję metod generatywnej sztucznej inteligencji.

Rozpoczął od omówienia klasycznych autoenkoderów i ich wariacyjnych odpowiedników (VAE), przechodząc przez modele GAN, VQ-VAE, PixelCNN, aż po najnowsze osiągnięcia w postaci latentnych modeli dyfuzyjnych (LDM) i systemów takich jak DALL·E. Prelegent szczegółowo opisał historyczny rozwój technik redukcji wymiarowości, koncepcję reprezentacji wewnętrznych oraz metody treningu bez nadzoru. Zgłębił mechanizmy działania modeli dyfuzyjnych, w tym ich zdolność do rekonstrukcji obrazów o wysokiej rozdzielczości oraz generowania treści wizualnych na podstawie opisów tekstowych.

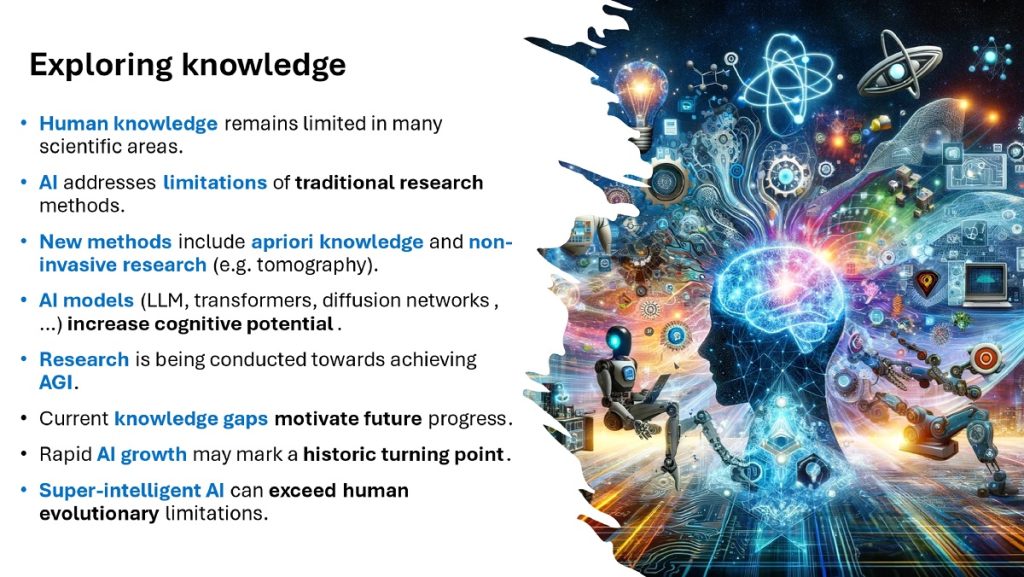

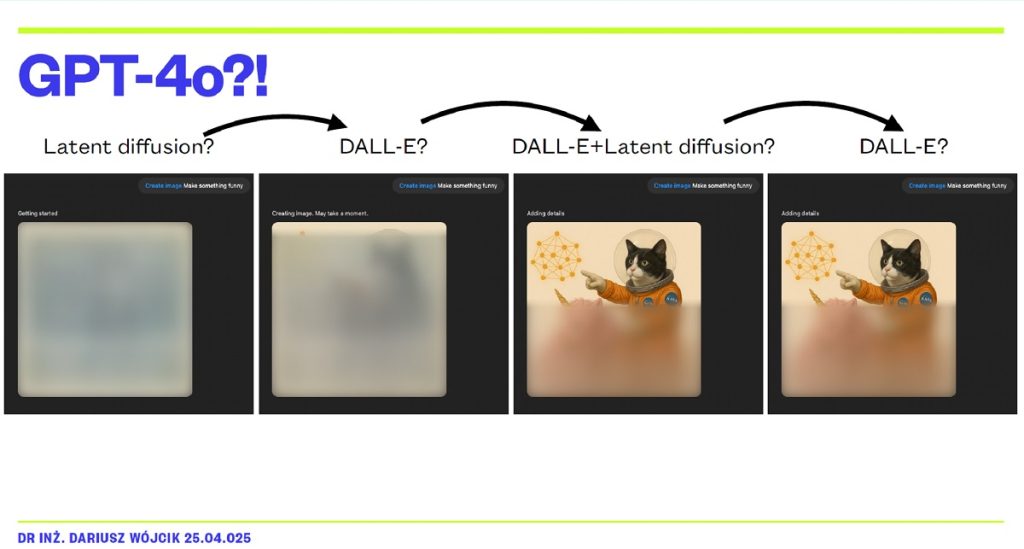

Autor zaprezentował również autorskie implementacje oraz zarysował otwarte pytania badawcze dotyczące integracji różnych architektur w przyszłych systemach generatywnych, kładąc szczególny nacisk na fundamentalne znaczenie reprezentacji latentnej (omawiając m.in. PCA, VAE, rozbieżność KL, VQ-VAE, CLIP, DM, LDM) i możliwości modeli takich jak GPT-4o.

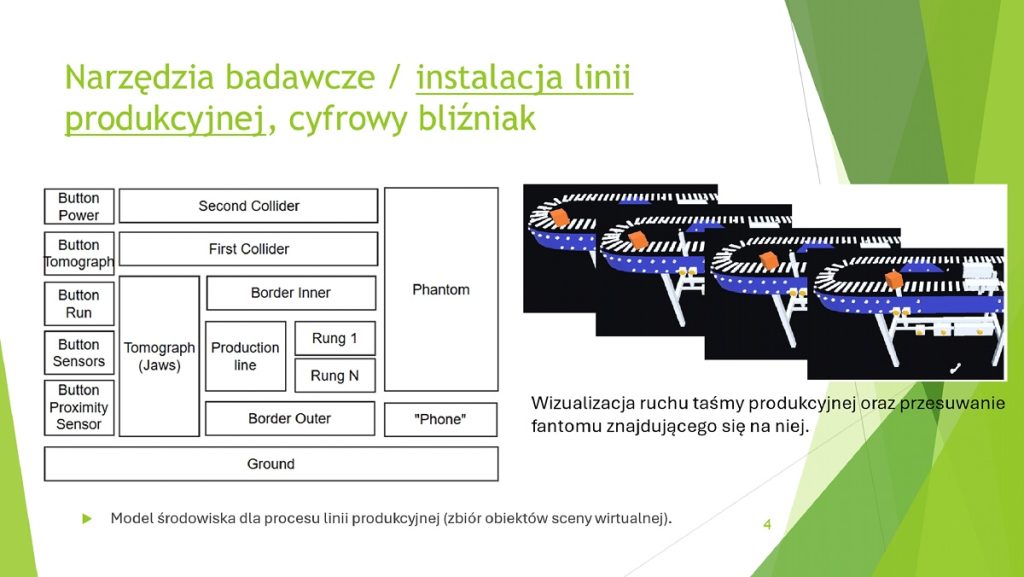

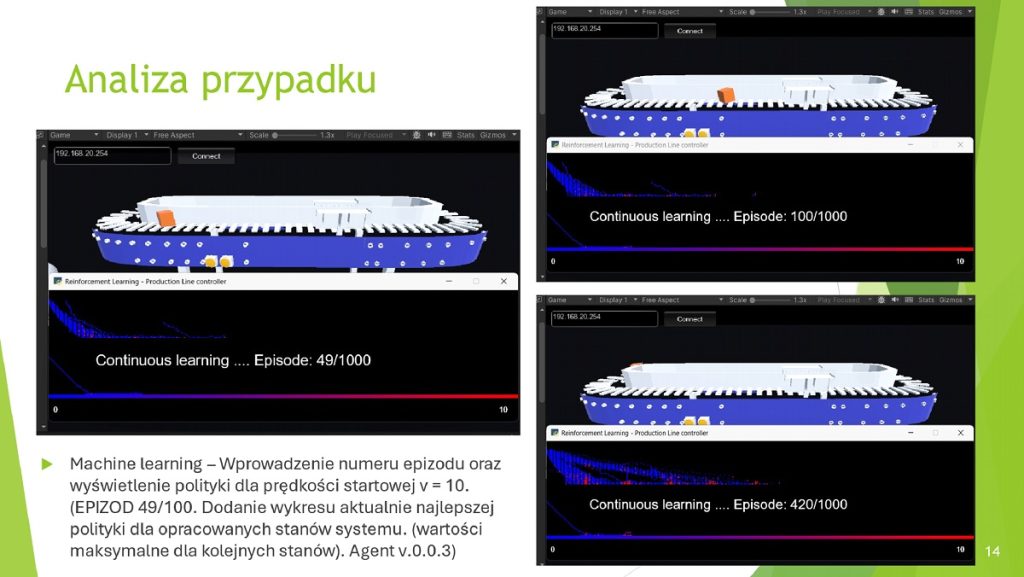

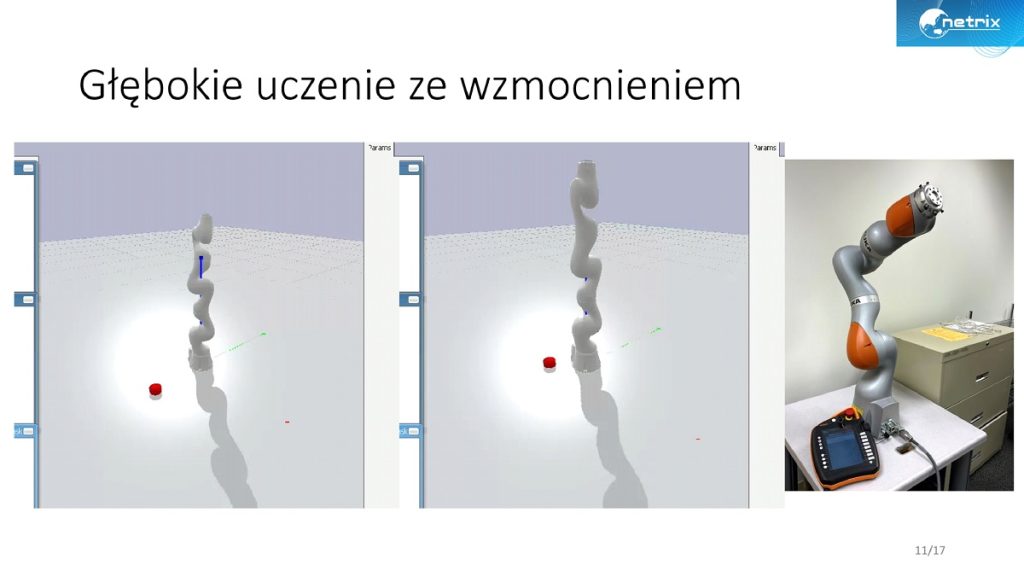

Trzeci wykład tematyczny, „Algorytmy i techniki uczenia ze wzmacnianiem w sterowaniu linią produkcyjną – analiza przypadku”, zaprezentował dr Grzegorz Rybak. Wykład koncentrował się na praktycznym zastosowaniu algorytmów uczenia ze wzmacnianiem do sterowania cyfrowym bliźniakiem linii produkcyjnej.

Prelegent omówił implementację środowiska symulacyjnego, wykorzystującego silnik Unity oraz model Hyleidos, w którym agent AI uczył się optymalnego sterowania prędkością linii produkcyjnej za pomocą algorytmu Q-learning oraz strategii epsilon-zachłannej (epsilon-greedy). Szczególną uwagę poświęcono analizie wyuczonych polityk sterowania oraz wpływowi systemu kar i nagród na efektywność działania agenta.

Przedstawiono kluczowe elementy RL (agent, środowisko, stan, akcja, nagroda, polityka, funkcja wartości, proces decyzyjny Markowa – MDP) oraz fragmenty kodu w Pythonie ilustrujące aktualizację Q-tabeli i polityki. Wyniki badań wskazały na możliwość znaczącej poprawy efektywności procesów przemysłowych dzięki zastosowaniu metod uczenia maszynowego w realistycznych warunkach symulacyjnych.

Sesja 1: S1. Innowacyjne technologie

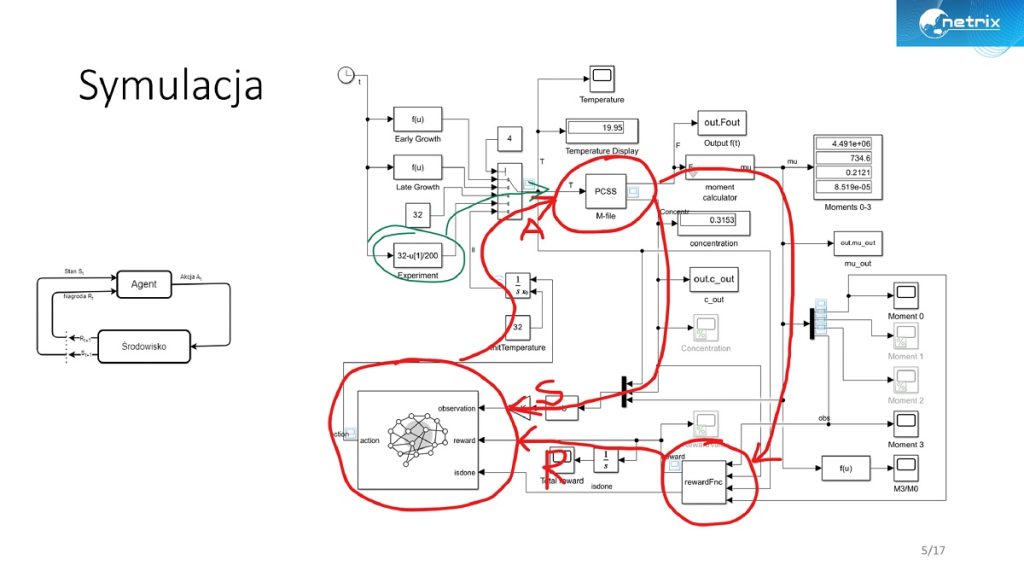

Konrad Niderla w prezentacji „Czy agent wie, czego chcemy? Funkcja nagrody dla procesu krystalizacji w uczeniu ze wzmocnieniem” poruszył problematykę definiowania funkcji nagrody w RL na przykładzie sterowania procesem krystalizacji z wykorzystaniem tomografii procesowej.

Omówił model środowiska symulacyjnego, gdzie celem agenta była optymalizacja parametrów procesu w celu uzyskania kryształów o pożądanych właściwościach.

Podkreślił wyzwania związane z niejednoznacznością i odroczonym w czasie sprzężeniem zwrotnym, które utrudniają efektywny trening agenta, oraz kluczowe znaczenie poprawnej definicji funkcji nagrody dla osiągnięcia stabilnych wyników.

Łukasz Ciuraj w wystąpieniu „Eksploracja potencjału cyfrowego bliźniaka w optymalizacji procesów produkcyjnych” przedstawił koncepcję cyfrowego bliźniaka jako narzędzia do optymalizacji parametrów linii produkcyjnych. Zaprezentował architekturę systemu (obejmującą symulator, moduł RL oraz interfejs użytkownika), mechanizmy zarządzania prędkością produkcji w celu minimalizacji drgań i utrzymania optymalnych warunków pracy.

Podkreślił różne poziomy zaawansowania cyfrowego bliźniaka (Digital Model, Shadow, Twin) oraz jego klasyfikację (Component, Product, Process, System Twin). Zaprezentował projekt prototypu cyfrowego bliźniaka środowiska produkcyjnego (iot-data-simulator, rl-service, digital-twin-backend, digital-twin-frontend), akcentując znaczenie integracji symulacji, danych sensorycznych i algorytmów AI dla rozwiązań Przemysłu 4.0.

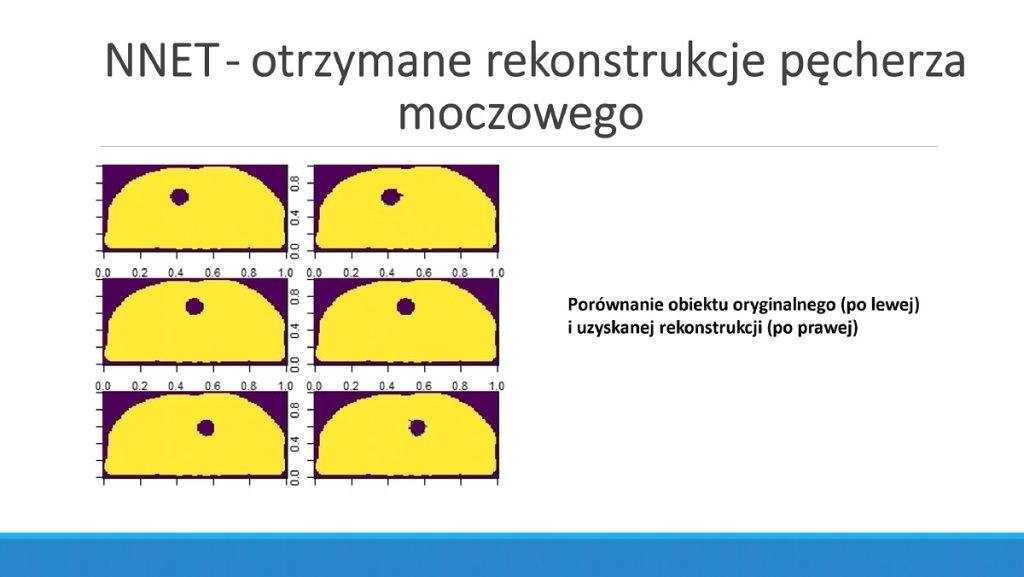

Marcin Dziadosz omówił „Zastosowanie algorytmów uczenia maszynowego w analizie pomiarowo-rekonstrukcyjnej pęcherza moczowego za pomocą Elektrycznej Tomografii Impedancyjnej”. Prezentacja skupiła się na aplikacji różnorodnych modeli uczenia maszynowego (m.in. Elastic Net, sieci neuronowe ANN i CNN, sieci rekurencyjne LSTM i GRU, a także algorytmy drzew decyzyjnych, XGBoost i Extremely Randomized Trees) do analizy danych z EIT.\

Przedstawił ich wykorzystanie w rozwiązywaniu zagadnień prostych i odwrotnych w kontekście obrazowania pęcherza moczowego, wskazując na możliwość uzyskania wysokiej jakości rekonstrukcji wspierających diagnostykę medyczną.

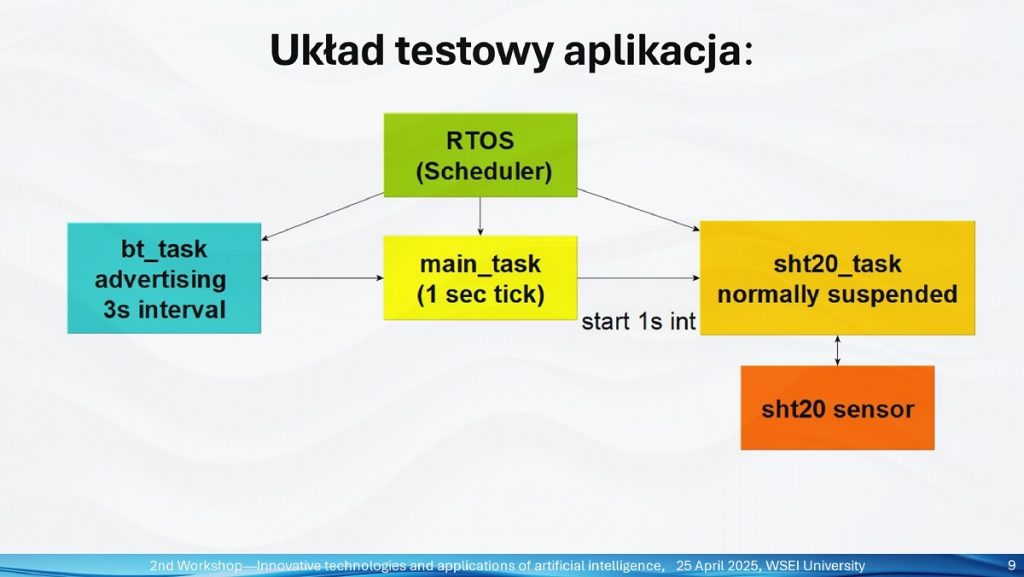

Michał Oleszek w prezentacji „Efektywne zarządzanie energią w układach IoT” zaprezentował praktyczne podejścia do optymalizacji zużycia energii w urządzeniach Internetu Rzeczy wykorzystujących technologię Bluetooth Low Energy (BLE).

Przeprowadził analizę wpływu parametrów takich jak moc nadawania i częstotliwość transmisji na czas pracy urządzeń zasilanych bateryjnie (CR2032). Omówił implementację systemu opartego na procesorze nRF52 z pomiarem wilgotności i temperatury oraz rolę systemów RTOS (tryby uśpienia, tickless idle). Wyniki testów wykazały możliwość znaczącego wydłużenia żywotności urządzeń dzięki odpowiedniej konfiguracji trybów pracy (np. długie interwały advertisingu, non-connectable advertising, tryb System OFF, dynamiczna zmiana mocy Tx) i parametrów komunikacyjnych.

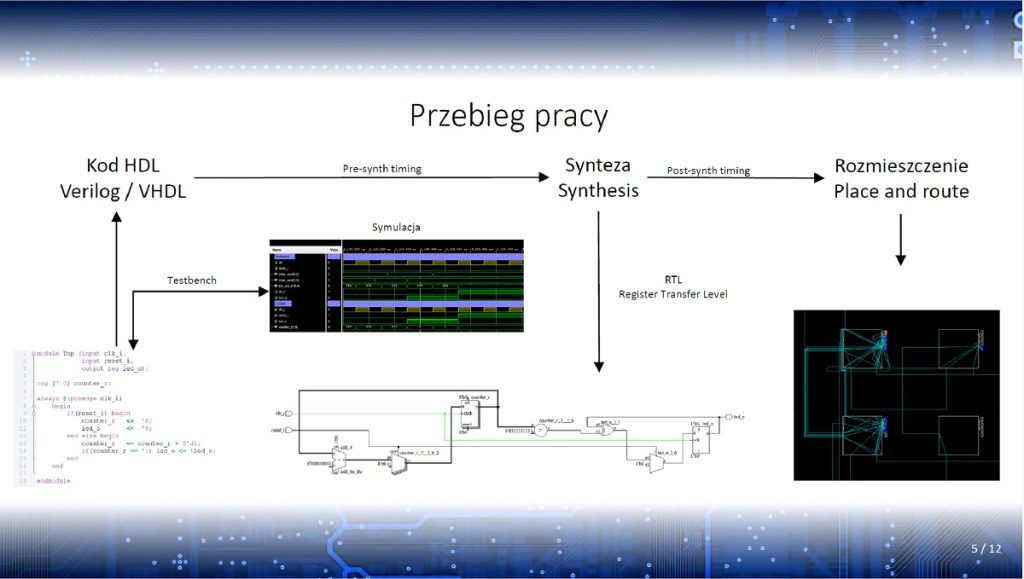

Tomasz Łobodiuk przybliżył „Zastosowanie układów FPGA w nowoczesnych układach pomiarowych”. Omówił zalety i ograniczenia wykorzystania programowalnych macierzy bramek logicznych (FPGA) w projektowaniu systemów pomiarowych.

Przedstawił proces projektowania, od kodowania w językach opisu sprzętu (HDL), przez syntezę i implementację, po symulację. Porównał możliwości FPGA z klasycznymi procesorami, wskazując na deterministyczną kontrolę czasu i elastyczność sprzętową, ale także na wyzwania związane z czasochłonnością rozwoju. Zaprezentował wewnętrzną strukturę FPGA (banki I/O, bloki RAM, LUT, FF, PLL) oraz przykłady implementacji liczników i systemów pomiarowych.

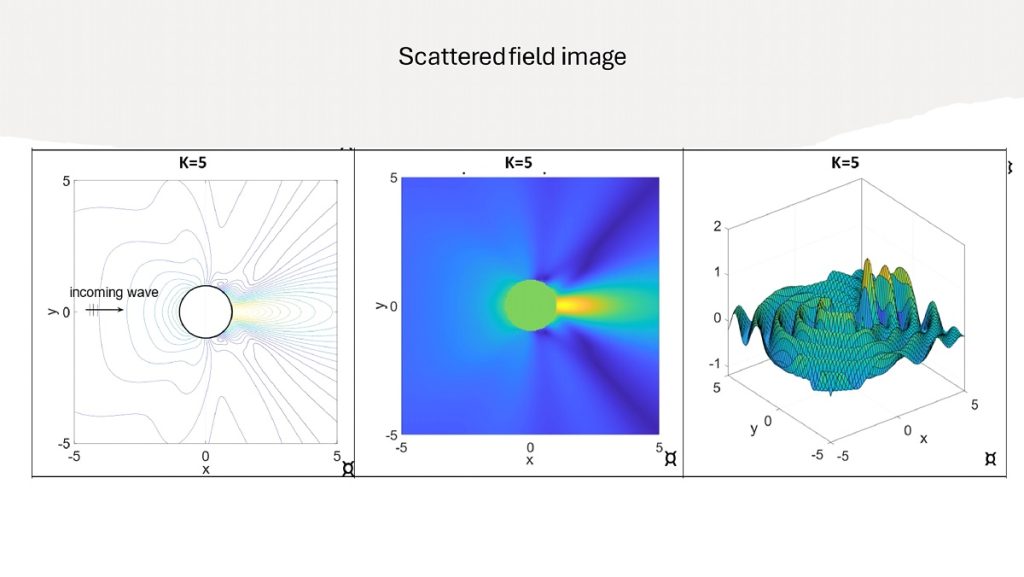

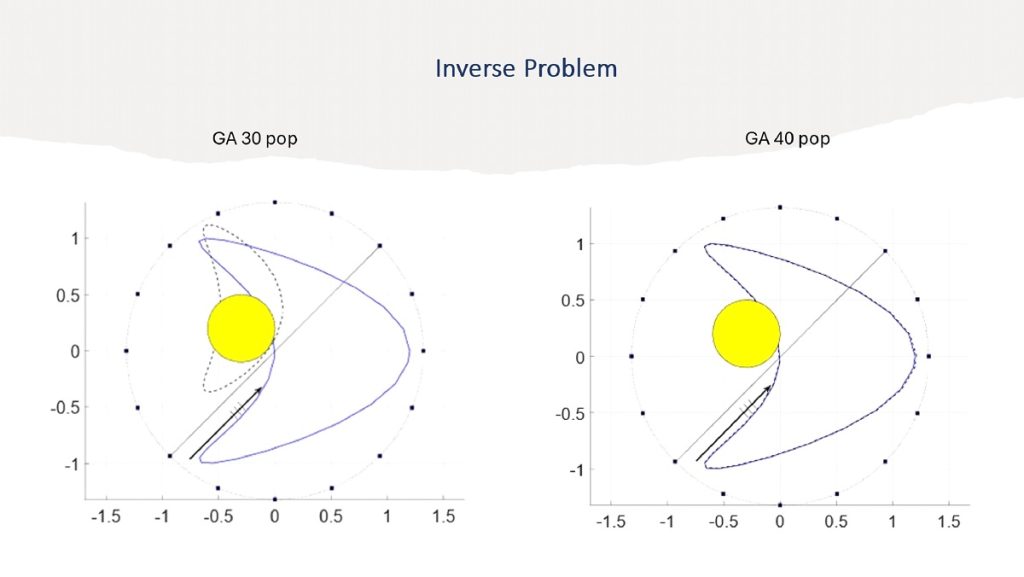

Wykład naukowy „Problemy odwrotne rozpraszania akustycznego z danymi bliskiego pola” wygłosił prof. Jan Sikora. Skupił się on na matematycznym opisie zagadnień odwrotnych w ultradźwiękowej tomografii akustycznej (USCT), która znajduje zastosowanie m.in. w obrazowaniu raka piersi czy badaniu stanu drzew.

Omówił modele matematyczne, w tym równanie Helmholtza oraz różne warunki brzegowe (Neumanna i Dirichleta). Zaprezentował podejścia analityczne i numeryczne, w tym metodę elementów brzegowych (BEM), oraz porównał je z rozwiązaniami analitycznymi (np. dla fali płaskiej i cylindrycznego rozpraszacza w reżimie Rayleigha z wykorzystaniem rozwinięcia Jacobiego-Angera).

Przedstawił wyniki eksperymentów z symulacjami obrazowania obiektów o złożonych kształtach przy użyciu danych bliskiego pola oraz metody optymalizacji deterministycznej i genetycznej w rozwiązywaniu problemów odwrotnych.

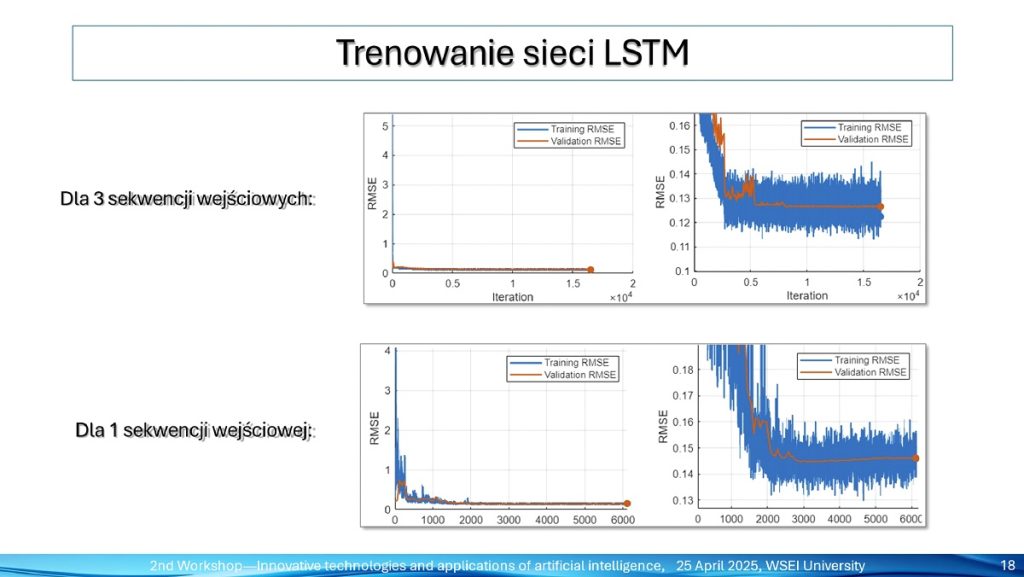

Następnie, dr Grzegorz Kłosowski w wykładzie tematycznym „Zastosowanie uczenia maszynowego w elektrycznej tomografii procesowej z sekwencjami pomiarowymi o zróżnicowanej częstotliwości” omówił nowatorską metodę obrazowania procesowego w reaktorach przemysłowych. Metoda ta wykorzystuje uczenie maszynowe i wieloczęstotliwościowe dane pomiarowe.

Zaprezentował architekturę modelu opartego na sieciach LSTM oraz sposób wykorzystania zespolonych wartości impedancji do poprawy jakości rekonstrukcji obrazów. Omówił również zastosowanie modelu Cole-Cole’a do odwzorowania właściwości dielektrycznych materiałów. Porównał model jednoczęstotliwościowy (pomiary czysto rezystancyjne) z modelem wieloczęstotliwościowym, wskazując, że podejście wieloczęstotliwościowe pozwala na lepszą identyfikację zmian w strukturze wewnętrznej reaktorów, szczególnie w obecności szumu.

Wskazał też na przyszłe kierunki badań, takie jak wieloczęstotliwościowa tomografia pojemnościowa (ECT) i hybrydowa (EIT+ECT).

Sesja 2: S2. Algorytmy, sensory i systemy tomograficzne

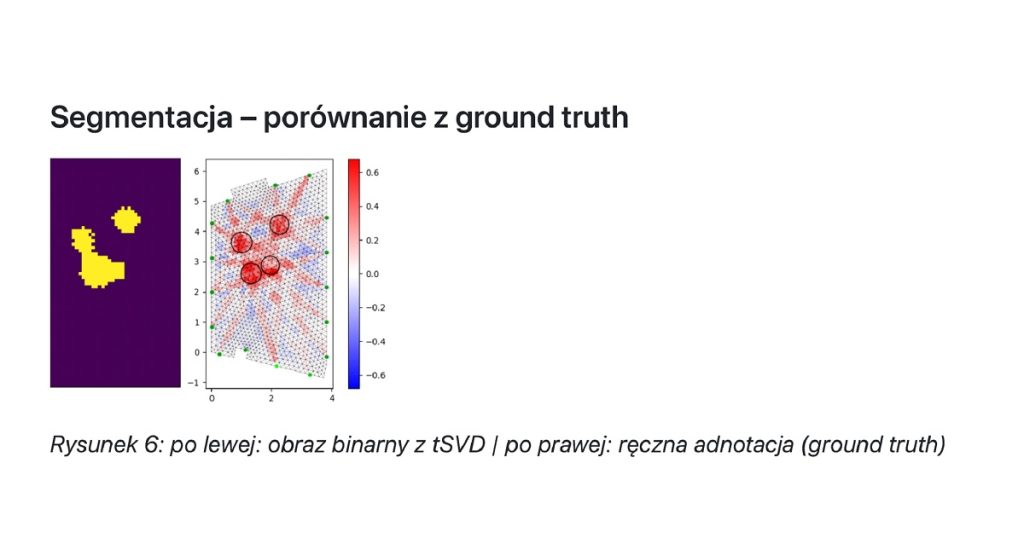

Michał Maj zaprezentował „Metody analizy obrazu w rekonstrukcji tomografii radiowej: położenie, kontur i estymacja obwodu osoby”. Referat omawiał metody analizy obrazów uzyskiwanych z tomografii radiowej 2D przy użyciu technik tSVD i regularyzacji Tichonowa. Zaprezentowano procedury segmentacji (binaryzacja, connected components), detekcji konturów oraz estymacji obwodu osób znajdujących się w polu pomiarowym.

Wyniki porównań wykazały przewagę metody tSVD pod względem jakości geometrycznej rekonstrukcji i stabilności konturów. Walidację przeprowadzono z użyciem kamery RGB, detekcji osób YOLOv7 oraz transformacji homograficznej.

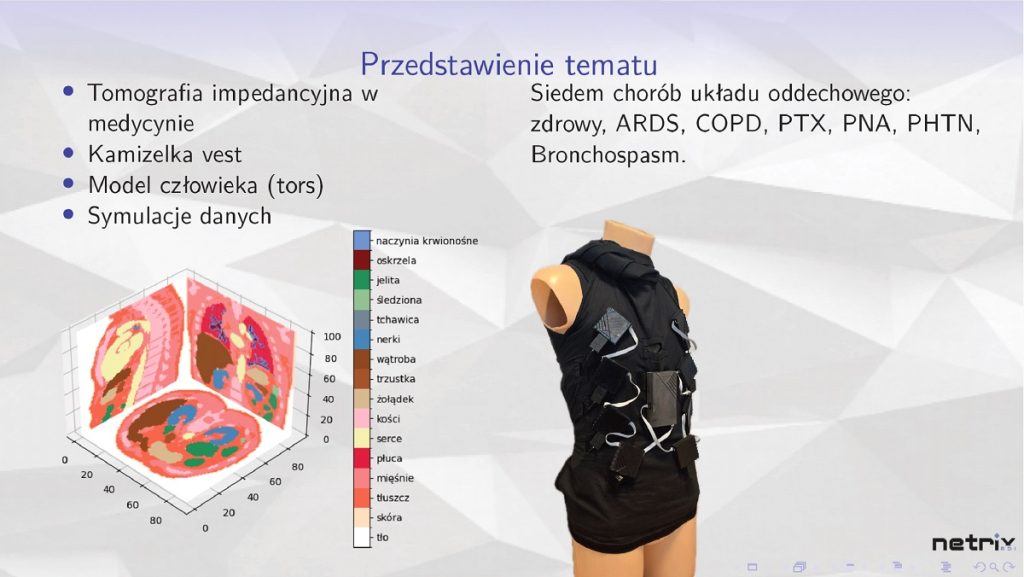

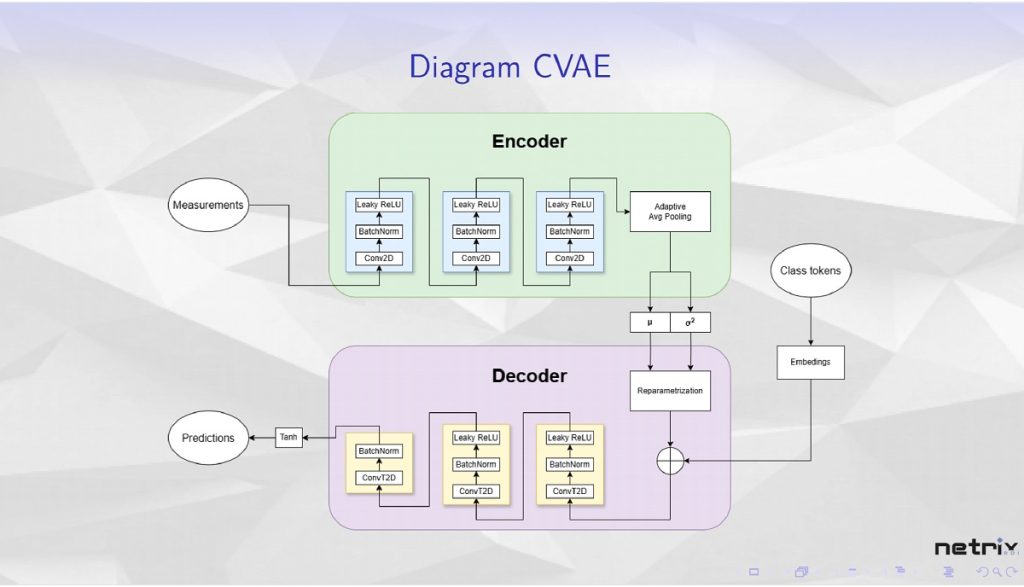

Barbara Stefaniak w wystąpieniu „Klasyfikacja danych z użyciem sieci typu encoder decoder z conv2D” poruszyła temat zastosowania warunkowych autoenkoderów wariacyjnych (CVAE) oraz hybrydowych sieci neuronowych z komponentem transformera do klasyfikacji obrazów z tomografii impedancyjnej (EIT).

Badania dotyczyły rozpoznawania schorzeń układu oddechowego na podstawie symulowanych danych EIT z modelu torsu człowieka. Zaprezentowała architekturę CVAE (z warstwami Conv2D, normalizacją wsadową, LeakyReLU i transponowanymi Conv2D) oraz hybrydowego klasyfikatora (zmodyfikowany ResNet50 + transformer z mechanizmem uwagi).

Wyniki uzyskane na bazie symulowanych danych oraz plany dalszego rozwoju modelu, w tym wzbogacenie go o dodatkowe źródła danych (np. sygnały aktywności serca), zostały omówione.

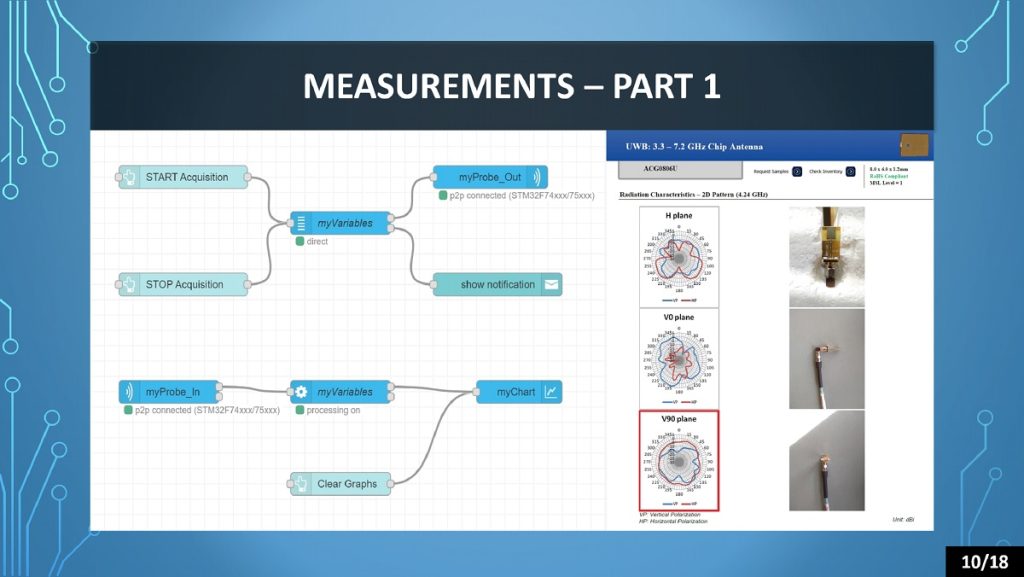

Michał Styła w prezentacji „Implementacja technologii ultraszerokopasmowych i metod czasowego określania dystansu w autorskich układach nadawczo-odbiorczych do nawigacji wewnątrzbudynkowej” omówił wdrożenie autorskiego systemu nawigacji wewnętrznej.

System ten oparty jest na technologii ultra-wideband (UWB) i metodach pomiaru czasu przelotu sygnału (Time of Flight – ToF), w szczególności technice SDS-TWR. Porównano dostępne na rynku moduły z rozwiązaniami własnymi pod kątem kosztów, niezawodności i elastyczności. Omówiono wyniki pomiarów odległości przed i po kalibracji, zastosowane algorytmy lokalizacyjne oraz użycie filtru Kalmana do wygładzania danych. Wskazano na potencjał rozwijanej technologii w zastosowaniach takich jak magazyny, inteligentne budynki i systemy bezpieczeństwa.

Dominik Gnaś przedstawił koncepcję urządzenia w referacie „Elektryczna Tomografia Impedancyjna Spektroskopowa do monitorowania poziomu glukozy we krwi”. Urządzenie to wykorzystuje tomografię impedancyjną spektroskopową (EIT-S, układ AD5933YRSZ) oraz optyczny czujnik (MAX30102) do nieinwazyjnego monitorowania poziomu glukozy we krwi.

Zaprezentowano projekt układu elektronicznego (mikrokontroler STM32F411), schematy, projekt PCB, plan kalibracji oraz założenia eksperymentalne, obejmujące pomiary impedancji i parametrów optycznych podczas różnych stanów metabolicznych. Prezentacja ukazała potencjał rozwijanej technologii w kierunku medycznych zastosowań diagnostycznych.

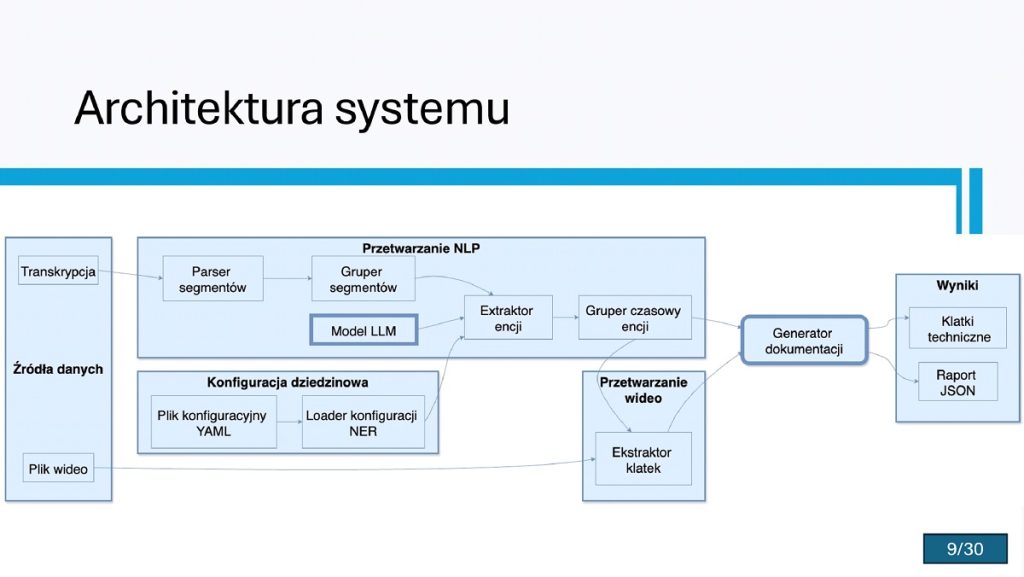

Ostatni wykład tematyczny przedstawił dr Tomasz Cieplak na temat „Znaczenie ontologii i baz wiedzy w zwiększaniu jakości dokumentacji technicznej tworzonej przez modele LLM na podstawie treści multimedialnych”. Wystąpienie prezentowało system wspomagania generowania i walidacji dokumentacji technicznej na podstawie filmów instruktażowych, z wykorzystaniem ontologii dziedzinowej.

Omówiono architekturę systemu, który analizuje transkrypcje i obrazy z filmów, wzbogacając je o metadane oraz poprawiając jakość terminologiczną i spójność semantyczną dzięki integracji z bazą wiedzy. Zwrócono uwagę na typowe problemy jakościowe dokumentacji generowanej przez LLM (niespójność, konfabulacja) oraz ograniczenia standardowego prompt engineeringu. Zaproponowano ontologię jako formalny model wiedzy.

Przedstawiono studium przypadku, ukazując, jak zastosowanie systemu (ekstrakcja encji, walidacja semantyczna) wpływa na precyzję opisów procedur i poprawność terminologii.

Sesja 3: S3. Aplikacyjne zastosowania AI

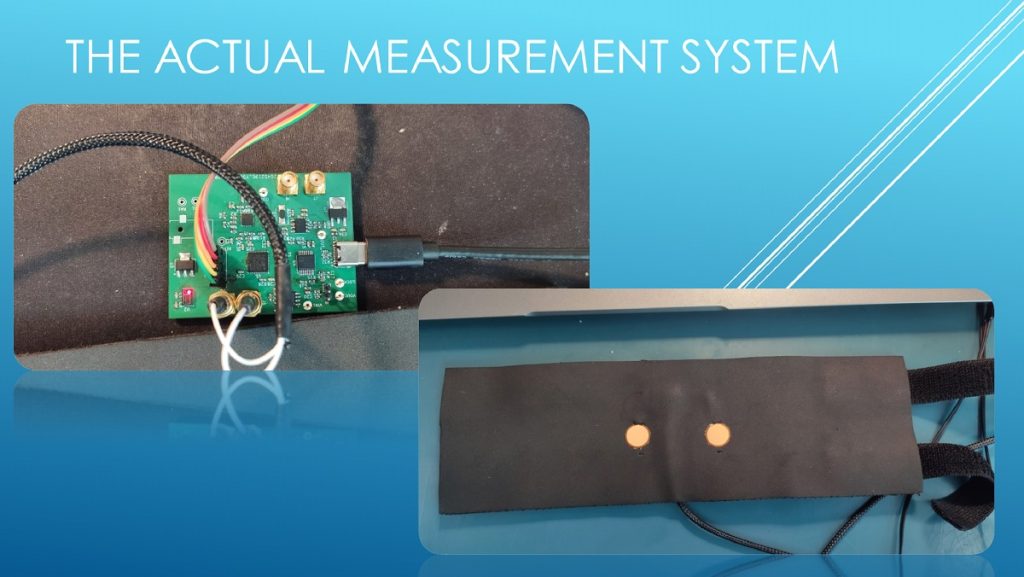

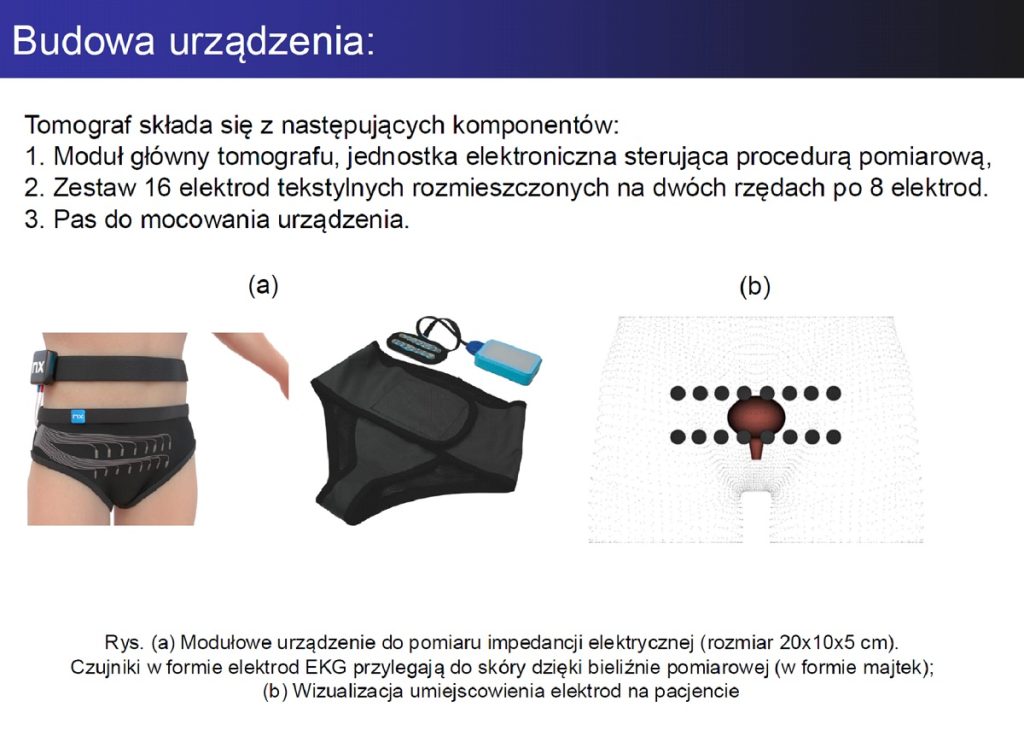

Dr Mariusz Mazurek omówił „Zastosowanie metod uczenia maszynowego w sensorach mobilnych wykorzystujących elektryczną tomografię impedancyjną”. Prezentacja dotyczyła opracowania bezinwazyjnego systemu monitorowania czynnościowych zaburzeń układu moczowego u dzieci, łączącego EIT, EMG i Tomografię Ultradźwiękową (UST).

Zaprezentowano budowę mobilnego sensora (z 16 elektrodami tekstylnymi), który umożliwia pomiar i rekonstrukcję obrazu pęcherza moczowego. Omówiono zastosowanie różnych algorytmów uczenia maszynowego (LARS, NNET, Elastic Net, drzewa decyzyjne), które znacząco poprawiają jakość obrazowania (NNET dał najmniejszy błąd). Projekt przeszedł certyfikację zgodności z normami medycznymi i ma potencjał do wdrożenia zarówno w placówkach medycznych, jak i w warunkach domowych.

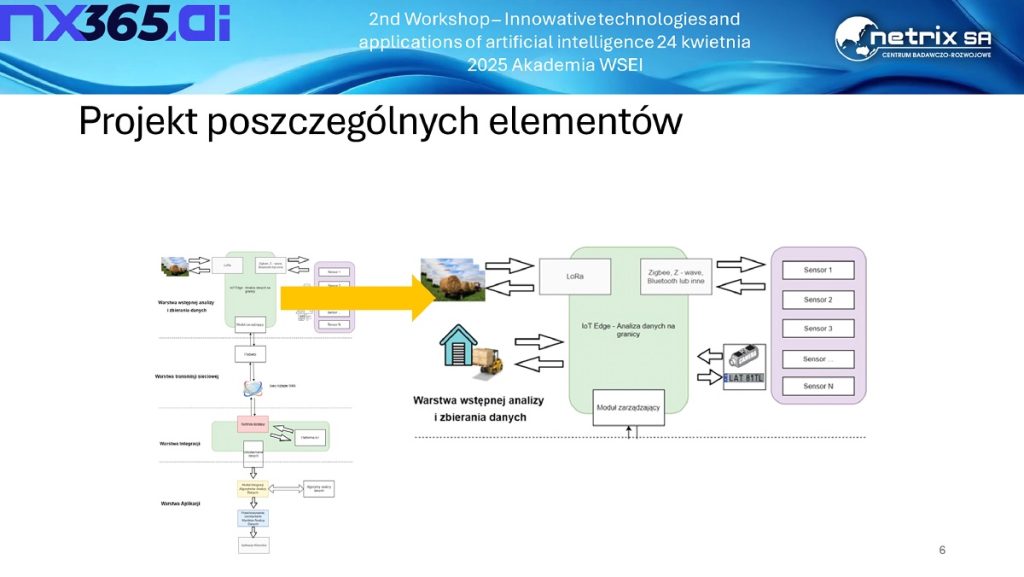

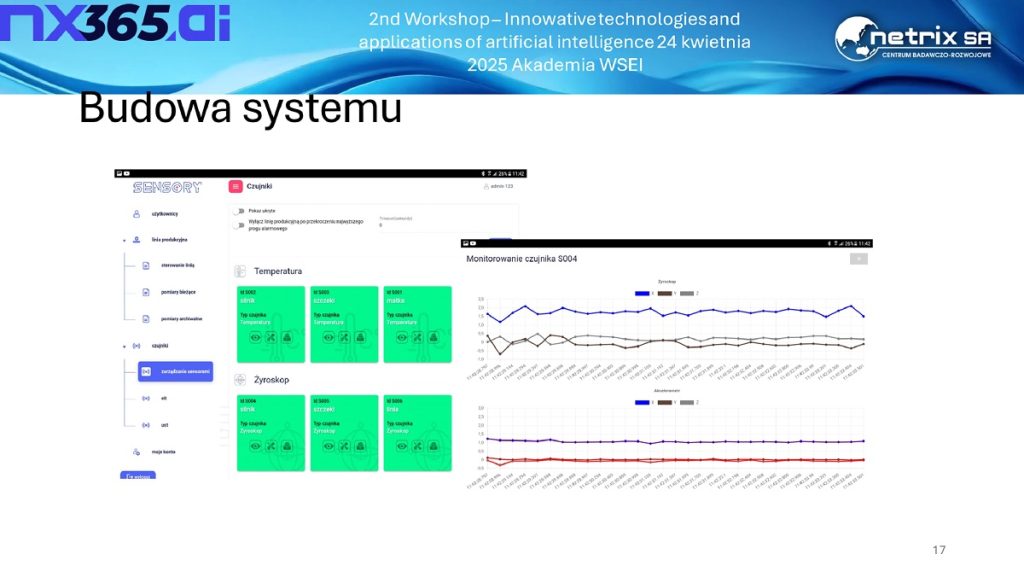

Krzysztof Król przedstawił „System do analizy i monitorowania parametrów produkcji procesowej”. Był to kompleksowy system do monitorowania parametrów procesów produkcyjnych i logistycznych, przeznaczony dla przedsiębiorstw produkcyjnych, biogazowni oraz elektrowni.

System wykorzystuje inteligentne sensory BLE do pomiaru temperatury, wilgotności, ciśnienia i wstrząsów.

Zaprezentowano architekturę systemu (warstwa zbierania danych IoT Edge, transmisji LoRa/Zigbee, integracji IoT, aplikacji klienckich), model linii produkcyjnej z różnymi sensorami i mechanizmami decyzyjnymi (np. drzewo decyzyjne), a także działanie aplikacji webowej umożliwiającej wizualizację danych i analizę jakości procesów. System został z powodzeniem przetestowany w środowisku produkcyjnym.

Marek Wójcik w prezentacji „AI w bezpieczeństwie sieci informatycznych” ukazał rolę sztucznej inteligencji w zapewnianiu cyberbezpieczeństwa. Omówił wykrywanie zagrożeń takich jak malware, phishing, ataki DDoS i ransomware. Skupił się na zastosowaniach AI w analizie anomalii, profilowaniu zachowań użytkowników i urządzeń (User and Entity Behavior Analytics – UEBA) oraz automatyzacji reakcji na incydenty bezpieczeństwa. Szczególną uwagę zwrócono na wykorzystanie NLP do analizy wiadomości e-mail pod kątem phishingu oraz na techniki rozpoznawania zautomatyzowanego ruchu w sieci.

Przedstawiono narzędzia takie jak Darktrace, Vectra AI i Microsoft Defender, wskazując również na wyzwania związane z przejrzystością decyzji AI (Explainability) oraz zagrożenia wynikające z użycia AI przez cyberprzestępców.

Paweł Kaleta omówił „Wykorzystanie chmury obliczeniowej w Lubelskiej Akademii WSEI”. Prezentacja dotyczyła wdrożenia prywatnej chmury obliczeniowej w Akademii WSEI. Omówiono podstawowe pojęcia związane z chmurą, jej rodzaje (publiczna, prywatna, hybrydowa) oraz praktyczne zastosowania w środowisku akademickim.

Zaprezentowano infrastrukturę serwerową uczelni (Fortinet, Dell EMC) oraz sposób korzystania z platformy chmurowej (VMware Horizon) przez studentów i pracowników, w tym dostęp do wirtualnych laboratoriów i specjalistycznego oprogramowania (LabView, SPSS, KNIME). Podkreślono zalety wykorzystania lokalnej infrastruktury chmurowej, która zapewnia elastyczność i bezpieczeństwo przetwarzania danych w ramach działalności edukacyjnej i badawczej.

Wydarzenie zakończyło się podsumowaniem, podczas którego organizatorzy podziękowali wszystkim prelegentom i uczestnikom za aktywny udział oraz cenne dyskusje. Zwrócono uwagę na rosnącą potrzebę integracji środowisk naukowych i przemysłowych wokół wspólnych projektów badawczo-wdrożeniowych, które mają potencjał realnie wspierać rozwój nowoczesnych technologii. Warsztaty potwierdziły, że Akademia WSEI staje się istotnym ośrodkiem wymiany wiedzy i doświadczeń w obszarze sztucznej inteligencji oraz technologii przyszłości. Organizatorzy zapowiedzieli kontynuację wydarzenia w kolejnych latach, podkreślając znaczenie dalszej współpracy interdyscyplinarnej i międzynarodowej.